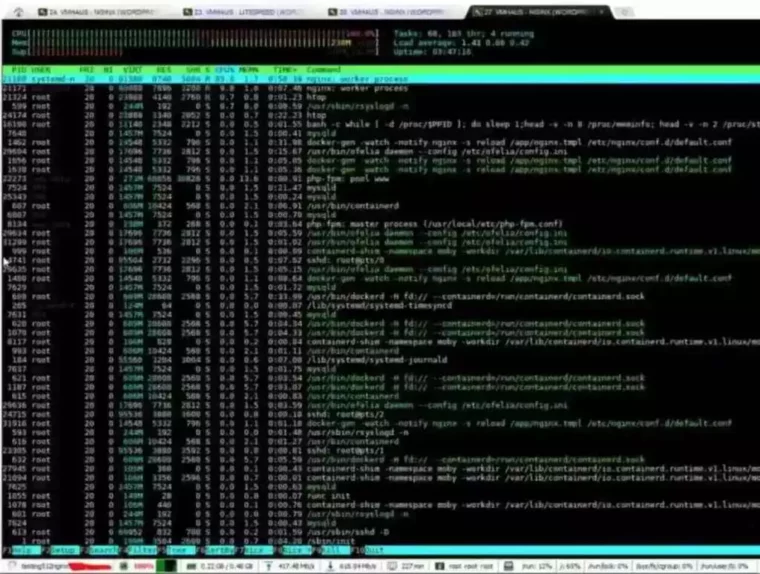

Его целью является сбор информации о страницах и их содержимом для последующей индексации. Эффективная балансировка нагрузки достигается путем настройки правил распределения трафика с учетом пиковых часов активности поисковых роботов и выделения для них отдельных серверных ресурсов. Интеграция CDN-сетей должна учитывать географическое распределение поисковых дата-центров для минимизации латентности. Регулярный мониторинг серверных метрик, включая использование CPU, RAM и пропускной способности сети, позволяет поддерживать оптимальную производительность системы для эффективного сканирования. Регулярный аудит помогает выявлять и устранять дубликаты страниц, которые могут возникать из-за различных параметров URL адресов или технических особенностей CMS.

Краулинговый Бюджет

Поэтому, если отчет не отображает того, что вы сделали со своим сайтом, значит вам нужно искать причину этого. Но в большинстве случаев вам не стоит беспокоиться о краунгивом бюджете. В мире search engine optimization самым большим фактором, для различия популярных страниц от непопулярных, является количество и тип обратных ссылок. Иерархическая структура сайта с глубиной не более 3-х уровней является идеальной структурой любого веб-сайта. В этом руководстве вы узнаете простым языком, что такое бюджет сканирования (и связанные с ним термины, а также то, как это влияет на search engine optimization краулинговый бюджет и какие действия вы можете предпринять для оптимизации. Чем выше удобство использования сайта, тем выше его поведенческие факторы, а они напрямую влияют на оценку качества сайта поисковиками, особенно Яндексом.

Внешние ссылки важнее, но их сложнее получить, в то время как внутренними ссылками, веб-мастеру намного легче управлять. Такая простая простая структура облегчает и ускоряет сканирование, а также это полезно для обычных пользователей. С самого начала следует подчеркнуть, что это не является фактором ранжирования. Да, в панелях вебмастеров есть специальные настройки, в которых можно задавать ограничения на скорость индексирования. Иногда оптимизаторами допускаются ошибки в редиректах, например, перенаправление происходит два и более раз. Фишка сравнительно новая, но жутко удобная – краулер изучает html-вариант веб-ресура, посетитель – JavaScript.

В первую очередь процесс начинается с установления baseline metrics для различных типов страниц и выявления трендов сканирования с учетом сезонности. Анализ корреляций между техническими изменениями и поведением поискового робота проводится через инструменты визуализации данных, позволяющие выявить причинно-следственные связи. Эффективный мониторинг поведения поисковых роботов требует комплексного анализа ключевых параметров и паттернов сканирования. Частота сканирования (crawl rate) отслеживается в динамике с учетом сезонности и типов контента, позволяя оптимизировать распределение бюджета. Анализатор логов выявляет характерные паттерны поведения роботов, включая предпочтительное время сканирования и интервалы между посещениями. Краулинговый бюджет — это лимит страниц, который поисковый робот (search bot) будет проверять за определенный промежуток времени.

Отметим, что ситуация усугубляется установленными приоритетами на индексацию страниц, частотой их обновления Стресс-тестирование программного обеспечения и уровнем вложенности самих страниц. Как результат, часть страниц будет просканирована поисковым роботом значительно позже. При этом, страницы которые действительно важны для сайта, могут быть не проиндексированы, поскольку краулинговый бюджет уже израсходован из-за сканирования дублированных страниц контента. Когда роботы поисковых систем посещают сайт, они начинают с домашней страницы, а затем переходят по любым ссылкам, чтобы обнаружить, просканировать и проиндексировать все страницы сайта. Если на сайте новых или обновлённых страниц значительно больше, чем успевает просканировать поисковый робот, необходимо оптимизировать бюджет.

Краулинговый Бюджет, Основы И Оптимизация

То есть это ограничение числа страниц, которые поисковой робот может проиндексировать в заданный временной промежуток. Краулинг (англ. crawling) в терминологии SEO — это сканирование поисковым роботом страниц сайтов, их индексация для формирования поисковой выдачи. Следовательно, чем большую нагрузку выдерживает наш сервер без ухудшений в скорости работы и без ошибок, тем лучше его сканирование. Автоматически настроить приоритеты сканирования можно с помощью файла xml карты сайта. Для этого в нем указывайте у всех страниц параметры lastmod и changefreq.

- Чем важнее страница, тем выше по уровню вложенности её необходимо располагать.

- В процессе технической оптимизации краулинговый бюджет оптимизируется через настройку ключевых параметров сканирования и процесс индексации.

- Краулинговый бюджет быстро тратится из-за ошибок индексации, поэтому задача SEO-специалиста — исправлять их.

- Краулинговый бюджет является важным аспектом для эффективной индексации вашего веб-сайта поисковыми роботами.

Для их обнаружения можно использовать инструмент проверки URL в Search Console или другие сервисы. Но при этом поисковые краулеры сами не переходят по ним и не запрашивают данные. Это помогает лучше оптимизировать все ссылки сайта, при этом сделав их недоступными для поисковых систем.

Через Логи Сервера

Продолжая использовать сайт, Вы соглашаетесь с использованием cookie-файлов. В статье разбираемся, почему брендам стоит обратить внимание на Threads, как работают алгоритмы платформы и как органично продвигаться. Узнайте еще больше фишек о продвижении собственного сайта на курс Поисковик . А с промо-кодом «Сrawling-07-10» Вы получите дополнительный бонус на него.

Глубокая настройка и отладка проекта не только приводит к резкому росту качества ресурса, но и позволяет сохранять положительный эффект на протяжении длительного времени. Иными словами, перспективы на попадание в содержание органической выдачи есть только у тех страниц, которые оказались в краулинговом бюджете. Это может быть большой проблемой, если речь идёт о масштабных изменениях, происходящих на тяжёлом многостраничном ресурсе. Оптимизация краулингового бюджета требует последовательного выполнения взаимосвязанных шагов. Страницы пагинации тоже забирают львиную часть краулингового бюджета.

При хороших показателях увеличивается и продуктивность поискового краулера на сайте. То есть за одинаковое количество соединений бот сможет просканировать больше контента, чем https://deveducation.com/ если страница будет притормаживать. Нужная информация находится на рисунке под названием «Количество сканированных страниц в день».

Основной проблемой плотной работы с краулинговым бюджетом может быть активное попадание в индекс незначительных страниц, содержащих смежные или сторонние ключевые вхождения. В крупных проектах бюджет эффективно управляется через автоматизированные системы мониторинга и контроля. При увеличении объема данных краулинговый бюджет масштабируется с помощью AI-алгоритмов и машинного обучения. Результаты каждого изменения измеряются через установленные метрики и сравниваются с прогнозируемыми показателями.

О том, зачем и как правильно настроить sitemap.xml и robots.txt мы подробно рассказывали ранее. Тщательная и грамотная проработка этих файлов важна и для целей оптимизации расхода краулингаового бюджета веб-сайта. Роботы Google далеко не всегда четко следуют нашим указаниям, но часто ориентируются именно на них.